Die Situation ist grotesk, aber aus technischer Sicht erklärbar: Während das Marketing-Team von YouTube Tutorials lobt, führt das Trust & Safety-Backend einen massiven Purge durch, der auf Heuristik-Fehlern basiert. Hier kollidieren automatisierte Content-Moderation-Skripte mit realen Archiv-Daten.

Tech-Briefing

- Vorfall: Massenhafte Terminierung von "How-To"- und Tutorial-Kanälen (teilw. >1 Mio. Subs, 13+ Jahre Archive) im "Late 2025"-Zeitfenster.

- Vektor: Vermutlich "Harmful & Dangerous Content"-Flagging durch verschärfte NLP/Vision-Modelle (False Positives bei Begriffen wie "Patch", "Crack", "Fix").

- Fehlerquelle: Das "Human Review"-System versagt bei Einsprüchen (Rubber-Stamping von KI-Entscheidungen).

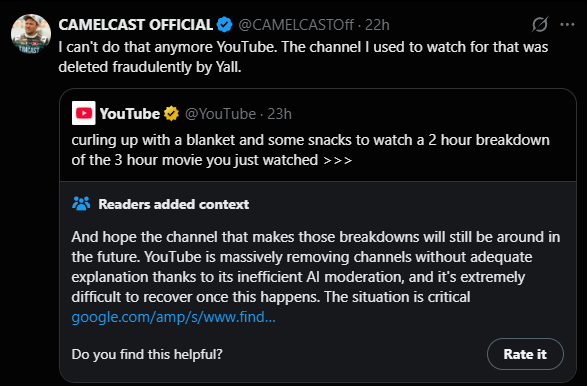

- Datenverlust: Kanäle werden "overnight" gelöscht; Wiederherstellung oft nur durch externen Druck (Twitter/X) möglich.

Diskrepanz zwischen Marketing-Front und Backend-Logik

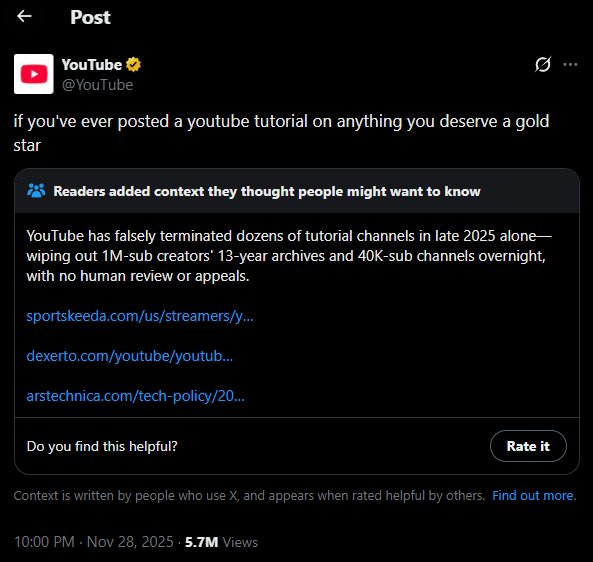

Die Screenshots illustrieren ein klassisches Silo-Problem in großen Tech-Konzernen. Der Tweet von @YouTube ("if you've ever posted a youtube tutorial [...] you deserve a gold star") ist eine rein marketinggetriebene Engagement-Kampagne. Parallel dazu operiert das Automated Content Enforcement System (ACES) völlig autark.

Die Community Note unter dem Marketing-Tweet liefert den entscheidenden Kontext: "YouTube has falsely terminated dozens of tutorial channels in late 2025". Das riecht nach einem kürzlich ausgerolltes Update der Moderations-Modelle. Wahrscheinlich wurde ein neuer Classifier in die Production-Pipeline gepusht, der pezifische Schlüsselwörter oder visuelle Muster in Tutorials (z.B. Screen-Recordings von Terminal-Fenstern, Software-Installationen oder Modding) fälschlicherweise als Richtlinienverstoß (z.B. "Instructional Hacking and Phishing") klassifiziert.

Der "Reviewer"-Fehler

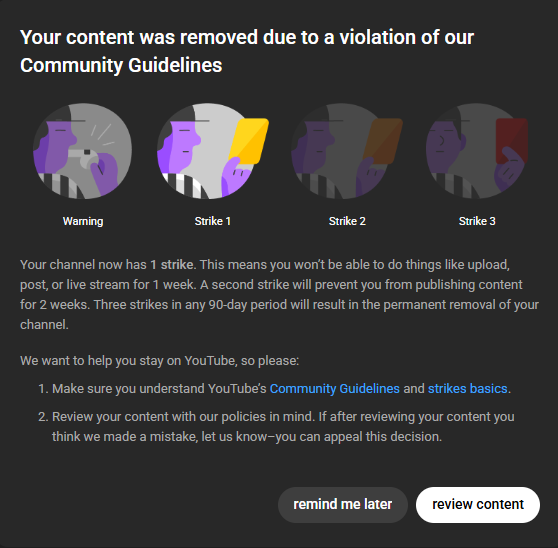

"One of our reviewers mistakenly upheld this strike during the appeal process when it should have been reinstated." via X

YouTube (und Google generell) verkauft das Content-ID- und Moderations-System als eine Kombination aus KI-Filter und menschlicher Überprüfung.

Die Realität sieht oft anders aus:

- Quota-Driven Moderation: Die "Reviewer" sind oft externe Kontraktoren (BPO - Business Process Outsourcing), die unter enormem Zeitdruck stehen. Die Metrik ist "Tickets pro Stunde", nicht "Qualität der Entscheidung".

- Bias Confirmation: Wenn die KI einen Inhalt bereits mit einer hohen Confidence-Score (z.B. 95% Wahrscheinlichkeit für Malware-Promotion) flaggt, neigt der menschliche Reviewer dazu, dem System blind zu vertrauen ("Rubber Stamping"), um die Ticket-Queue abzuarbeiten.

- UI-Design: In vielen Moderations-Dashboards ist der "Uphold Strike" (Bestätigen) Button oft prominenter oder der Default-Pfad, während ein "Reinstate" (Wiederherstellen) eine Begründung erfordert, was Zeit kostet.

Die Aussage"mistakenly upheld" beweist, dass der Appeal-Prozess kein Sicherheitsnetz ist, sondern oft nur eine zweite Instanz des Versagens. Dass erst ein viraler Tweet auf einer Konkurrenzplattform (X/Twitter) nötig ist, um einen "echten" Menschen mit Admin-Rechten zu erreichen (Escalation Level 2 oder 3), ist quasi kurz vor Shitstorm ("Support via Public Shaming").

Warum trifft es Tutorial-Kanäle?

Tutorial-Kanäle sind anfällig für False Positives, da sie sich in einer Grauzone der NLP (Natural Language Processing) bewegen:

- Vokabular: Ein Tutorial "How to recover a lost password" nutzt ähnliche Vokabeln wie "How to hack an account". Für kontext-schwache Modelle ist der Unterschied minimal.

- Visuelle Trigger: Das Zeigen von Code, Registry-Edits (Windows) oder CLI-Befehlen (Linux) wird von Bilderkennungsalgorithmen oft als "Hacking" oder "Umgehung technischer Schutzmaßnahmen" geflaggt.

- Link-Richtlinien: Tutorials enthalten oft Links in der Beschreibung (zu GitHub, Drive, etc.). Wenn eine dieser Domains auf einer Blacklist landet oder ein Binary als "Potentially Unwanted Program" (PUP) geflaggt wird, reißt das den ganzen Kanal mit.

Das Risiko des "Digital Wipeout"

Benutze youtube auf keinen Fall als Backup-Lösung. Wenn ein Kanal "terminiert" wird, sind die Videos nicht einfach nur unsichtbar (Private/Unlisted), sondern der Zugriff auf das Creator Studio wird gesperrt.

Technisch gesehen liegen die Daten zwar oft noch eine Zeit lang im "Cold Storage" (Soft Delete), bevor sie endgültig überschrieben werden (Hard Delete), aber ohne Zugriff auf das Interface hat der Creator keine Möglichkeit, seine Daten zu exportieren (Google Takeout funktioniert oft nicht mehr für gesperrte Brand Accounts).

Die Abhängigkeit von einer einzigen Plattform für das Hosting von Knowledge-Bases (was Tutorials faktisch sind) erweist sich hier als fataler "Single Point of Failure".

Handlungsableitung für Content Creator

Wer technische Tutorials hostet, muss diesen Vorfall als Warnschuss verstehen:

- 3-2-1 Backup: YouTube ist kein Backup. Alle Rohdaten und finalen Renders müssen lokal und idealerweise auf einem zweiten physischen Medium oder S3-Bucket gespeichert werden.

- Plattform-Diversifizierung: Spiegelung der Inhalte auf Odysee (LBRY-Protokoll) oder PeerTube. Diese sind resistenter gegen zentralisierte "False Positive"-Löschwellen.

- Metadaten-Sanitization: Überprüfung alter Video-Beschreibungen. Tote Links oder Links zu Software, die heute als "Riskware" gilt, können rückwirkend Strikes auslösen.

Es bleibt abzuwarten, ob YouTube das zugrundeliegende Modell-Update zurückrollt oder ob dies der neue Standard für die "Safety"-Heuristik bleibt. Aktuell ist die "Error Rate" der Moderation inakzeptabel hoch.