Identitätsprüfung oder Überwachungsmaschine? 53 Megabyte Quellcode auf einem Regierungsserver verraten mehr, als Persona und OpenAI jemals öffentlich machen wollten

Wer in den letzten Monaten ChatGPT genutzt, sich bei Discord verifiziert oder sein Alter auf Roblox bestätigt hat, wurde möglicherweise deutlich gründlicher durchleuchtet als gedacht.

Drei unabhängige Sicherheitsforscher – bekannt unter den Pseudonymen vmfunc, MDL und Dziurwa – haben am 16. Februar 2026 eine technische Analyse veröffentlicht, die das gesamte Ausmaß der Identitätsprüfung durch den KYC-Dienstleister Persona offenlegt.

Kurz & Knapp

- 53 MB ungeschützter TypeScript-Quellcode lag offen auf einem FedRAMP-autorisierten US-Regierungsserver – 2.456 Dateien, ohne jede Authentifizierung abrufbar

- Der Code dokumentiert 269 einzelne Verifizierungschecks, darunter Gesichtserkennung gegen Watchlists, Selfie-Verdachtsanalysen und biometrische Gesichtsdatenbanken mit bis zu 3 Jahren Speicherfrist

- Persona betreibt dieselbe Codebasis sowohl für kommerzielle Kunden (OpenAI, Discord, Roblox) als auch für US-Regierungsbehörden auf einer separaten FedRAMP-Plattform

- Ein dedizierter Endpunkt namens „openai-watchlistdb.withpersona.com" existiert laut Zertifikats-Logs seit November 2023 – 18 Monate bevor OpenAI die ID-Verifizierung öffentlich ankündigte

- Im Quellcode finden sich Module zum direkten Einreichen von Verdachtsmeldungen (SARs) an FinCEN, das US-Finanzministerium, sowie an die kanadische FINTRAC – inklusive Codenamen aktiver Geheimdienstprogramme

Was genau wurde gefunden?

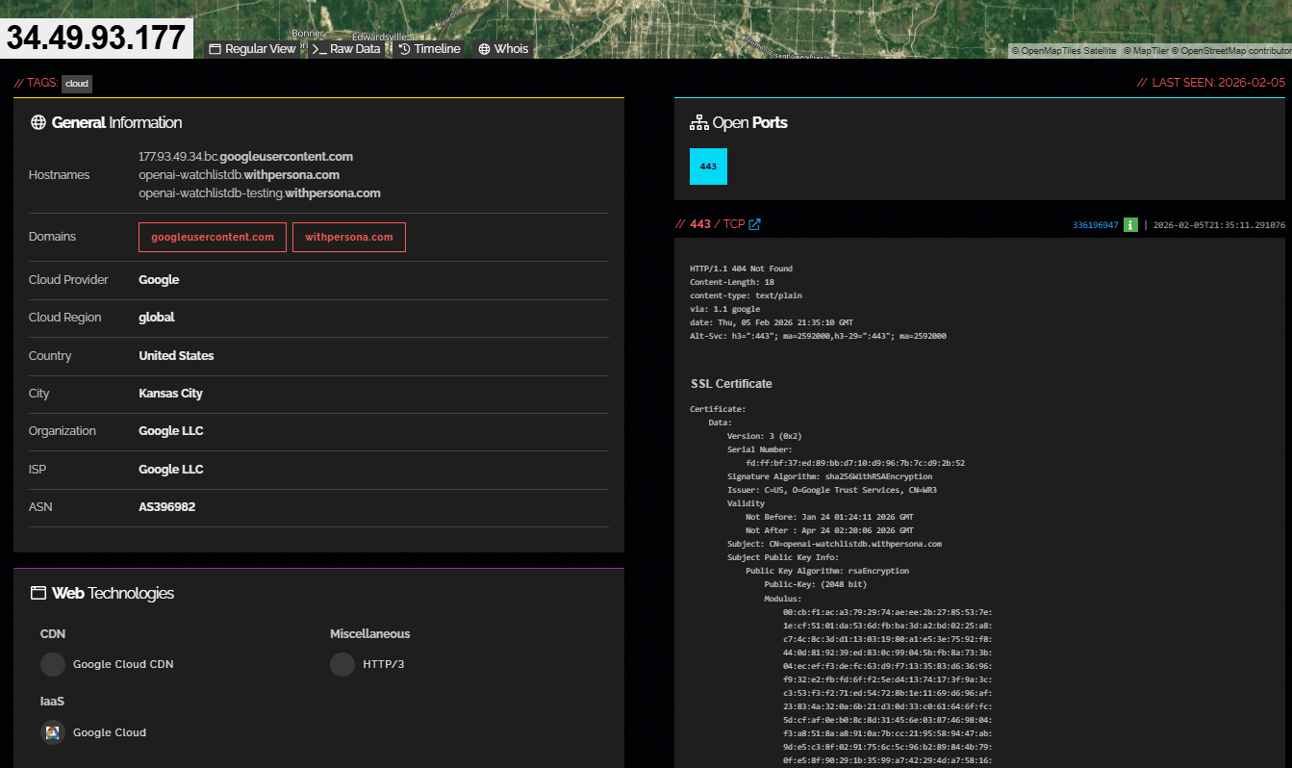

Die Forscher betonen, dass kein System gehackt wurde. Ihre Methodik basiert ausschliesslich auf passiver Aufklärung: Shodan-Abfragen, DNS-Auflösungen, Certificate-Transparency-Logs und öffentlich ausgelieferte JavaScript-Source-Maps. Ein einzelner Shodan-Treffer auf die IP-Adresse 34.49.93.177 – ein Google-Cloud-Server in Kansas City – enthüllte zwei Hostnamen, die den Stein ins Rollen brachten: openai-watchlistdb.withpersona.com und openai-watchlistdb-testing.withpersona.com.

Nicht „openai-verify", nicht „openai-kyc". Watchlistdb. Eine Watchlist-Datenbank, dediziert für OpenAI, auf eigener Infrastruktur abseits von Personas regulärem Cloudflare-Setup.

Die Architektur: Vom Selfie zur Verdachtsmeldung

Persona ist ein in San Francisco ansässiges Unternehmen, das sich auf Identitätsprüfung spezialisiert hat. OpenAI, Discord, Roblox, LinkedIn und Lime gehören zu den Kunden. Laut Personas eigener Fallstudie screent OpenAI über den Dienst monatlich Millionen von Nutzern, wobei „über 99 Prozent automatisch im Hintergrund in Sekunden" verarbeitet werden.

Was der offengelegte Quellcode nun zeigt, geht über eine einfache Sanktionslistenprüfung hinaus. Die Datei lib/verificationCheck.ts enthält einen Enum mit 269 einzelnen Verifizierungschecks, aufgeteilt auf 14 Kategorien.

Darunter finden sich neben erwartbaren Prüfungen wie dem Abgleich von Selfie und Ausweisfoto auch weniger offensichtliche Funktionen:

SelfieSuspiciousEntityDetection – dein Gesicht wird als „verdächtig" eingestuft. Was genau eine Entität verdächtig macht, definiert der Code nicht. Der Nutzer erfährt davon nichts.

SelfiePublicFigureDetection – ein Abgleich, ob du einer bekannten Persönlichkeit ähnlich siehst. Dazu gleich mehr.

SelfieExperimentalModelDetection – experimentelle, namentlich nicht benannte Machine-Learning-Modelle werden auf deine biometrischen Daten angewandt. Auf einer Produktivumgebung.

SelfieFaceCoveringDetection und SelfieGlassesDetection – Maske? Markiert. Brille? Vermerkt.

Hinzu kommen 43 Checks für Ausweisdokumente (inklusive NFC-Chip-Auslesen und AAMVA-Datenbankabfragen für US-Führerscheine), 27 Datenbankprüfungen (darunter ein Abgleich mit der US-Sterbedatei der Social Security Administration) und 29 Dokumentenchecks, die nach PDF-Editoren, synthetischen Inhalten und digitalen Textmanipulationen suchen.

Gesichtserkennung gegen Politiker-Datenbanken

Das vielleicht absurdeste Detail der gesamten Untersuchung findet sich in den Dateien PoliticallyExposedPersonV2EntityMatchDetails.tsx und PoliticallyExposedPersonPhotoComparison.tsx. Ein vollständiges PEP-Screening-System (Politically Exposed Persons) vergleicht dein Selfie mit einer Datenbank bekannter Politiker, Staatsoberhäupter und deren erweitertem Familienkreis – inklusive eines Ähnlichkeits-Scores in drei Stufen: Low, Medium und High.

PEP-Screening-Stufen laut Quellcode

| Attribut | Beschreibung |

|---|---|

| Ähnlichkeitsstufen | Low, Medium, High |

| Referenzbilder | Wikidata-Porträtfotos |

| PEP-Klassen | 1 (Staatsoberhäupter), 2 (Familienmitglieder), 3 (enge Vertraute), 4 (erweiterte Kontakte) |

| Matching-Optionen | Spitznamen, Transliterationen, Abkürzungen, Geburtsort, Nationalität |

Die Forscher schreiben in ihrem Bericht, sie hätten den entsprechenden Codeabschnitt dreimal lesen müssen, bevor sie ihren Augen trauten. Dein Selfie – ursprünglich hochgeladen, um einen Chatbot nutzen zu können – wird gegen eine globale Politikerdatenbank gescannt und erhält einen biometrischen Ähnlichkeitswert. Ob du davon erfährst? Nein.

Pikantes Randdetail: Der Quellcode verweist auf einen bekannten Bug im PEP-System. Ein TODO-Kommentar lautet sinngemäss, es gebe „keine Parität zwischen Version 2.0 und 1.0". Zwei parallele PEP-Screening-Systeme laufen also mit bekannten Inkompatibilitäten – auf einer Plattform, die darüber entscheidet, ob eine Person dem Finanzministerium gemeldet wird.

Direkte Meldungen an FinCEN und FINTRAC

Der Quellcode enthält ein vollständiges SAR-Modul (Suspicious Activity Report), das über einen „Send to FinCEN"-Button direkt Verdachtsmeldungen an das Financial Crimes Enforcement Network des US-Finanzministeriums übermittelt. Der gesamte Lebenszyklus einer SAR ist abgebildet: Erstellen, Validieren gegen das FinCEN-XML-Schema, elektronisches Einreichen, Status-Tracking (akzeptiert, abgelehnt, archiviert).

Parallel dazu existiert ein STR-Modul (Suspicious Transaction Report) für FINTRAC, das kanadische Pendant. Die STR-Formulare im Code enthalten ein Dropdown-Menü mit Codenamen aktiver Geheimdienstprogramme:

- Project SHADOW

- Project LEGION

- Project GUARDIAN

- Project CHAMELEON

- Project ATHENA

- Project ANTON

- Project PROTECT

Das sind reale öffentlich-private Partnerschaftsprogramme von FINTRAC. Jede Verdachtsmeldung kann über dieses Dropdown einem aktiven Geheimdienstprogramm zugeordnet werden – hartcodiert im Quellcode einer kommerziellen KYC-Plattform.

13 Arten von Tracking-Listen und biometrische Datenbanken

Laut der Datei list.ts pflegt die Plattform 13 verschiedene Listentypen: Ausweissnummern, IP-Adressen, Namen (mit Fuzzy-Matching), Telefonnummern, E-Mail-Adressen, Geolokationen, Browser-Fingerprints, Geräte-Fingerprints, Gesichter, Länder, Formularfelder, beliebige Strings und Selfie-Hintergründe.

Gesichter und Selfie-Hintergründe sind als „Enhanced"-Listentypen klassifiziert und erfordern spezielle biometrische Badges. Die maximale Speicherdauer für biometrische Gesichtslisten beträgt laut Code drei Jahre (1.095 Tage) – OpenAIs eigene Datenschutzrichtlinie spricht von „bis zu einem Jahr". Welche Angabe stimmt, bleibt ungeklärt.

Die Regierungsplattform: Gleicher Code, andere Adresse

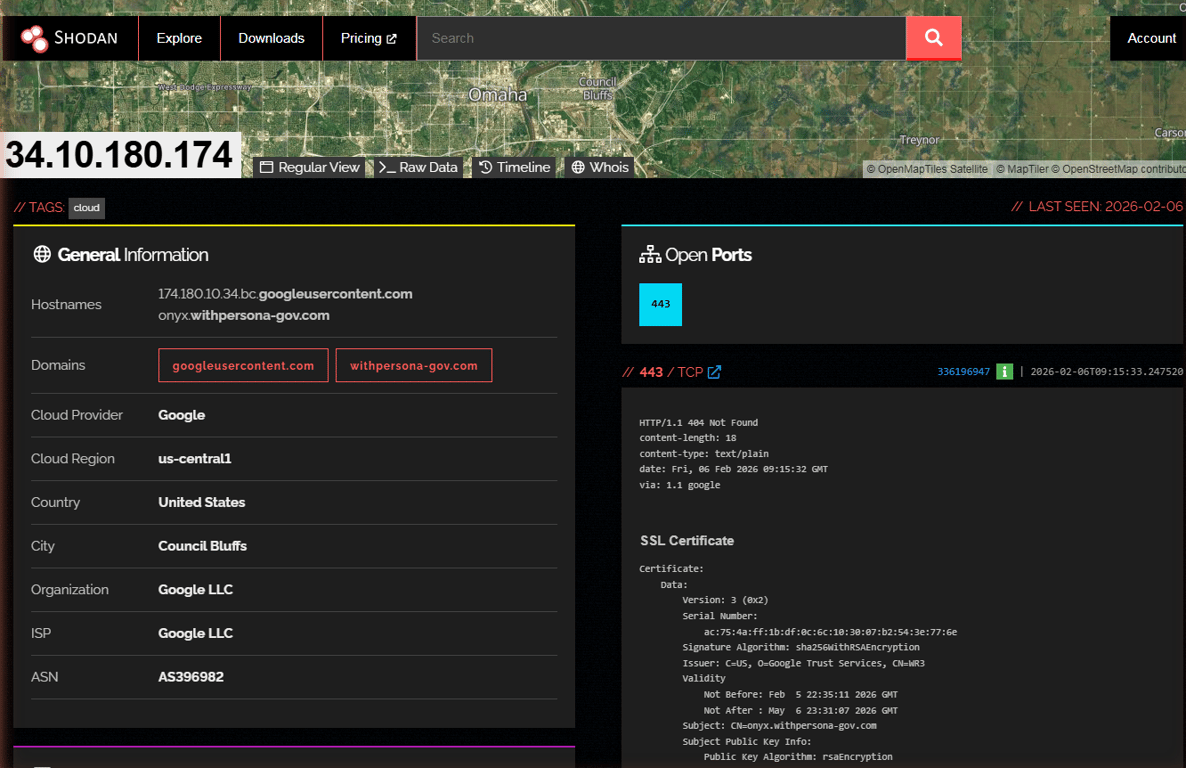

Parallel zur kommerziellen Infrastruktur entdeckten die Forscher withpersona-gov.com – Personas FedRAMP-autorisierte Plattform für US-Bundesbehörden, gehostet auf einem separaten Google-Cloud-Server in Googles Iowa-Rechenzentrum. Die Plattform erhielt am 7. Oktober 2025 die FedRAMP-Autorisierung auf „Low Impact"-Stufe.

Der entscheidende Punkt: Es handelt sich um dieselbe Codebasis. Die Forscher bestätigten dies über übereinstimmende Git-Commit-Hashes. Dasselbe Unternehmen, das dein Passfoto verarbeitet, wenn du dich bei ChatGPT oder Discord verifizierst, betreibt eine Regierungsplattform mit SAR-Meldungen, biometrischen Gesichtsdatenbanken und Geheimdienstprogramm-Tags.

ONYX: Ein Name, viele Fragen

Am 4. Februar 2026 – zwölf Tage vor der Veröffentlichung der Untersuchung – tauchte eine neue Subdomain in den Certificate-Transparency-Logs auf: onyx.withpersona-gov.com. Eigene Google-Cloud-Instanz, eigenes Kubernetes-Namespace (persona-onyx), eigene Wildcard-Zertifikate.

Der Name „ONYX" stimmt mit Fivecast ONYX überein, einem KI-Überwachungstool, das die US-Einwanderungsbehörde ICE für 4,2 Millionen Dollar beschafft hat. Fivecast ONYX sammelt laut EFF-Berichten automatisiert Multimedia-Daten aus sozialen Medien und dem Dark Web, erstellt „digitale Fussabdrücke" und vergibt Risiko-Scores.

Die Forscher betonen allerdings ausdrücklich: Im Quellcode finden sich null direkte Verweise auf Fivecast, ICE, Einwanderungsbehörden oder Social-Media-Überwachung. Der ONYX-Namensgleichklang ist dokumentiert, aber nicht bewiesen. Der Code auf diesem Deployment ist ein KYC/AML-Compliance-System – kein Überwachungstool im engeren Sinne.

Wie 53 Megabyte Quellcode auf einem Regierungsserver landeten

Die Source-Maps lagen auf dem Login-Dashboard unter app.onyx.withpersona-gov.com/dashboard/login im Pfad /vite-dev/. Vite, das Build-Tool des Projekts, generiert während der Kompilierung .js.map-Dateien, die den vollständigen Originalquellcode als JSON-Strings enthalten. Im Normalbetrieb deaktiviert die Produktionskonfiguration diese Maps. Hier allerdings deutet der /vite-dev/-Pfad darauf hin, dass entweder ein Development-Build deployed oder die Docker/Kubernetes-Konfiguration aus einer Dev-Stufe der CI-Pipeline gezogen wurde.

Personas CEO Rick Song reagierte innerhalb von 24 Stunden nach Veröffentlichung. In einer öffentlich gemachten E-Mail-Korrespondenz bestätigte er, dass das betroffene Cluster eine neue Entwicklungsumgebung sei, nicht die produktive FedRAMP-Instanz.

Er bedankte sich für den Hinweis auf die Source-Maps und erklärte, das Problem werde behoben. Song betonte zudem, dass Persona aktuell keine aktiven Verträge mit DHS oder ICE habe – räumte aber ein, dass das Unternehmen aktiv nach Regierungsaufträgen suche.

Was das für Discord-Nutzer ab März bedeutet

Das Timing der Enthüllung könnte kaum brisanter sein. Ab März 2026 führt Discord eine weltweite verpflichtende Altersverifizierung ein. Alle Konten – auch solche, die seit Jahren existieren – werden automatisch in einen „Teen-by-Default"-Modus versetzt. Wer weiterhin 18+-Server betreten, uneingeschränkt Direktnachrichten empfangen oder in Stage-Channels sprechen will, muss sein Alter per Gesichtsscan oder Ausweisupload bestätigen.

Discord bestätigte, dass Persona im Rahmen eines Tests in Grossbritannien als Verifizierungspartner eingesetzt wurde. Der Test sei „abgeschlossen", so Discord – wie die globale Verifizierung langfristig technisch umgesetzt wird, bleibt offen. Die erhobenen Daten sollen laut Discord nur sieben Tage gespeichert werden. Der nun offengelegte Quellcode zeigt Speicherfristen von bis zu drei Jahren für biometrische Daten.

Roblox nutzt Personas Gesichtsaltersschätzung und ID-Verifizierung ebenfalls als Kern seines „Age Checks to Chat"-Systems. LinkedIn, Coursera und der Ride-Sharing-Dienst Lime stehen gleichfalls auf Personas Kundenliste.

Chainalysis-Integration: Krypto-Wallets unter Dauerbeobachtung

Ein Detail, das besonders in der Krypto-Community für Aufsehen sorgt: Die Datei ChainalysisAddressScreening.tsx dokumentiert eine vollständige Integration des Blockchain-Analysetools Chainalysis. Kryptowährungsadressen werden nach Risikolevel bewertet (severe, high, medium, low), Cluster-Zuordnungen durchgeführt und Dollar-Beträge pro Expositionskategorie angezeigt.

Das System ist kein einmaliger Check, sondern ein persistenter Monitor. Ein recurring-enabled: true in der Report-Template-Konfiguration sorgt dafür, dass einmal erfasste Wallet-Adressen in konfigurierbaren Intervallen erneut gegen Chainalysis' Cluster-Graph geprüft werden – automatisch und ohne Benachrichtigung des Nutzers.

Die OpenAI-Verbindung: Copilot statt Daten-Pipeline

Ein Punkt, den mehrere Berichte übersprungen haben: Die Verbindung zu api.openai.com in der Content-Security-Policy ist kein Datenaustausch von Nutzerdaten mit OpenAI. Der Code zeigt einen KI-Assistenten namens „AskAI" für Dashboard-Operatoren, kategorisiert neben Slack und Zendesk als Produktivitätstool. Standard-SSE-Streaming, OpenAI als ExternalIntegrationProductivityOpenAi.

Was trotzdem Fragen aufwirft: Dieser KI-Copilot läuft auf derselben Regierungsplattform, die SARs verarbeitet, biometrische Gesichtsdatenbanken pflegt und Watchlist-Screenings durchführt. Welche Kontextinformationen der Copilot einsehen kann, während ein Operator gerade eine Verdachtsmeldung prüft, dokumentiert der Code nicht.

Was der Code nicht zeigt

Transparenz verlangt auch, die Grenzen der Erkenntnisse klar zu benennen. In 2.456 Quelldateien finden sich:

- Null Verweise auf ICE, Einwanderungsbehörden, Abschiebungen oder Grenzschutz

- Null Verweise auf Fivecast oder ONYX als Produkt

- Keine klassischen Überwachungsvendoren wie Palantir, Clearview oder NEC

- Kein bidirektionaler Datenaustausch zwischen OpenAI-Nutzerdaten und dem SAR-System

- Keine Strafverfolgungsfunktionen wie Haftbefehlsverwaltung oder Beweisketten

Die Plattform ist ein Finanz-Compliance-System, das von Regierungsbehörden genutzt wird. Ob und wie Daten aus der kommerziellen Nutzung (ChatGPT, Discord) in die Regierungsplattform fliessen, beweist der Code nicht. Aber er beweist, dass Persona beide Systeme betreibt, beide dieselbe Software nutzen und beide aktiv sind.

Die offenen Fragen

Die Forscher listen 18 konkrete Fragen auf, die Persona und OpenAI beantworten müssten. Die drängendsten für Gamer und Discord-Nutzer:

- Wogegen hat OpenAI im November 2023 gescreent – 18 Monate bevor die Identitätsprüfung öffentlich angekündigt wurde?

- Was genau macht ein Gesicht „verdächtig" im Sinne von

SelfieSuspiciousEntityDetection? Welche Merkmale triggern diesen Flag? - Wie lang werden biometrische Daten tatsächlich gespeichert? OpenAI sagt ein Jahr, der Code sagt drei Jahre, Ausweisdaten offenbar „permanent".

- Werden Nutzer darüber informiert, dass ihr Selfie einem PEP-Gesichtsabgleich unterzogen wird – dass die Plattform prüft, ob ihr Gesicht einem Politiker ähnelt?

- Persona-CEO Rick Song hat zugesagt, alle 18 Fragen schriftlich zu beantworten. Die vollständige Korrespondenz soll als Part 2 (Blog/Persona) der Untersuchung veröffentlicht werden. Zum Zeitpunkt dieses Artikels stehen die Antworten noch aus.

Wie die Branche reagiert

Persona erklärte in einem privaten Briefing an Partner, dass die Infrastruktur für Regierungsmeldungen zwar existiere, man aber aktuell keine aktiven Verträge mit DHS oder ICE habe – obwohl man aktiv nach solchen Aufträgen suche.

Die Reaktion der Sicherheits-Community fiel gemischt aus. Der Sicherheitsforscher Alon Gal schrieb auf LinkedIn, dass „routinemässige ID-Checks für OpenAI-Nutzer in eine dedizierte Watchlist-Datenbank eingespeist werden, die seit 2023 operativ ist". Malwarebytes, Cybernews und Dataconomy griffen die Untersuchung auf. Vx-underground, ein bekanntes Malware-Research-Kollektiv, teilte die Erkenntnisse ebenfalls.

Die Forscher sahen sich allerdings auch mit den Schattenseiten der Veröffentlichung konfrontiert: Eine ursprünglich im Bericht enthaltene Namensliste von Persona-Mitarbeitenden – extrahiert aus Quellcode-Kommentaren – musste nach Morddrohungen gegen Praktikanten und Berufseinsteiger entfernt werden.

„Wenn deine Reaktion auf Forschung darin besteht, einen Praktikanten zu bedrohen, hast du den gesamten Sinn verpasst", schrieb vmfunc auf X.

Einordnung: Compliance-Infrastruktur oder Überwachungssystem?

Die Wahrheit liegt, wie so oft bei solchen Enthüllungen, in einem unbequemen Graubereich. Personas Plattform tut zu einem erheblichen Teil genau das, was KYC/AML-Systeme im Finanzsektor seit Jahren tun: Sanktionslisten abgleichen, PEP-Screenings durchführen, Verdachtsmeldungen an Behörden weiterleiten. Banken, Krypto-Börsen und Zahlungsdienstleister arbeiten mit vergleichbaren Werkzeugen.

Was die Situation anders macht: Diese Werkzeuge werden nun auf Nutzer eines Chatbots und einer Gaming-Kommunikationsplattform angewandt. Millionen von Menschen, die ein Selfie hochladen, um mit einer KI zu chatten oder einen Discord-Server zu betreten, durchlaufen dieselbe Prüfinfrastruktur, die für die Bekämpfung von Geldwäsche und Terrorismusfinanzierung gebaut wurde. Ob das verhältnismässig ist, muss jeder für sich beurteilen.

Die Illinois Biometric Information Privacy Act (BIPA) verlangt eine informierte schriftliche Einwilligung vor der Erhebung biometrischer Daten, eine Offenlegung von Zweck und Speicherdauer sowie einen öffentlich zugänglichen Aufbewahrungsplan. Bei „Millionen monatlicher Screenings" und gesetzlichen Schadensersatzansprüchen von 1.000 bis 5.000 Dollar pro Verstoss dürfte die potenzielle Haftungssumme beträchtlich sein. Gegen Persona laufen in Illinois bereits Sammelklagen wegen angeblich unrechtmässig gespeicherter biometrischer Daten.

Für Discord- und ChatGPT-Nutzer: Was du jetzt tun kannst

Wer die Altersverifizierung bei Discord oder die Identitätsprüfung bei OpenAI noch nicht durchlaufen hat, sollte sich der oben beschriebenen Verarbeitungskette bewusst sein, bevor er ein Selfie hochlädt. Wer die Verifizierung ablehnt, behält bei Discord eingeschränkten Zugang im Teen-Modus. Bei OpenAI ist der Zugang zu fortgeschrittenen Modellen ohne Verifizierung nicht möglich.

Die Forscher schliessen ihren Bericht mit einem Satz, der nachhängt: „Wenn jemand dich bittet, ein Selfie zu machen, um zu beweisen, dass du ein Mensch bist – frag dich, wer auf der anderen Seite der Kamera sitzt und auf welcher Liste du gerade gelandet bist."

Quellen: Originalbericht, Persona Case Study, Cybernews, Malwarebytes, Dataconomy, Boycat Times, piunikaweb.com (CEO-Korrespondenz), DL News, BFcom (Discord-Altersverifizierung)