OpenAI hat einen Leitfaden zur Interaktion mit GPT-5 veröffentlicht, der sich gezielt an Entwickler richtet. Die neuen Paradigmen erfordern eine tiefgreifende Anpassung der bisherigen Prompting-Strategien und offenbaren ein System, das weniger wie ein Befehlsempfänger und mehr wie ein Junior-Entwickler agiert. Wir analysieren die technischen Implikationen für Code-Generierung, API-Interaktion und komplexe Software-Architekturen.

GPT-5 API-Nutzung: Technischer Deep Dive in OpenAIs neuen Prompting-Guide

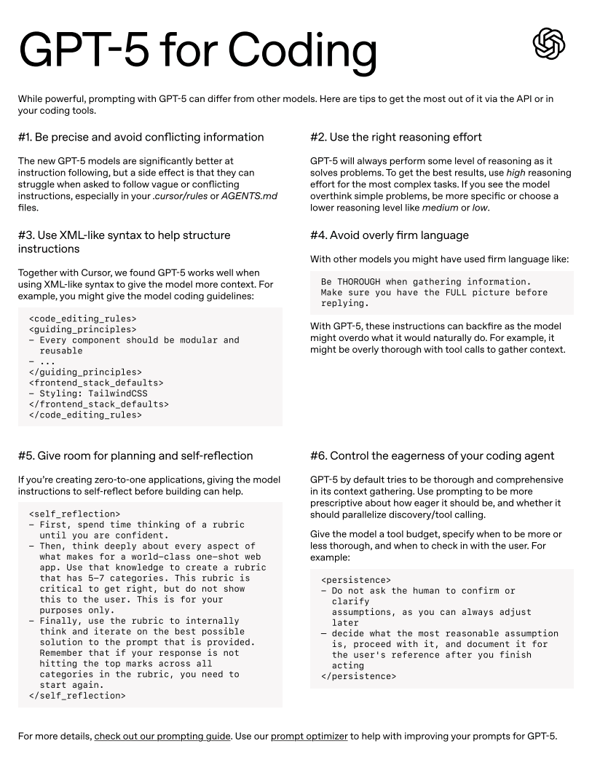

Die Art und Weise, wie Entwickler mit Large Language Models interagieren, steht vor einer grundlegenden Veränderung. Die von OpenAI im „Cookbook“ publizierten Richtlinien für GPT-5 machen deutlich, dass simple Anweisungen zur Code-Generierung der Vergangenheit angehören. Das neue Modell verlangt nach strukturierten, logisch konsistenten und kontextuell präzisen Prompts, um seine volle Leistungsfähigkeit zu entfalten.

Für Programmierer bedeutet dies eine Verlagerung von der reinen Aufgabenstellung hin zur detaillierten Spezifikation und Prozesssteuerung. Anstatt nur ein Ziel vorzugeben, definierst du nun die Leitplanken, Werkzeuge und Verhaltensregeln für einen KI-gesteuerten Prozess. Dieser Paradigmenwechsel ist der Kern des sogenannten „Agentic Coding“, bei dem der Entwickler vom reinen Coder zum Architekten und Dirigenten autonomer Systeme wird.

Imperativ Präzision: Konsistenz als Compiler-Voraussetzung

Die gesteigerte Fähigkeit von GPT-5, Anweisungen exakt zu folgen, hat eine direkte technische Konsequenz: Das Modell reagiert empfindlich auf logische Widersprüche und Ambiguität, ähnlich einem strikten Compiler. Ein Prompt, der beispielsweise in einem Teil eine zustandslose (stateless) Architektur fordert, in einem anderen aber implizit zustandsbehaftete (stateful) Operationen beschreibt, wird zu fehlerhaftem oder unbrauchbarem Code führen. Bei der Definition von Algorithmen, State Machines oder komplexen Klassen-Interfaces müssen alle Constraints und Anforderungen konfliktfrei sein. Die Qualität des Prompts korreliert direkt mit der Kompilierbarkeit und logischen Korrektheit des Outputs.

API-Kosten und Latenz: Den reasoning_effort gezielt steuern

Die neue Möglichkeit, die Denkleistung des Modells über den Parameter reasoning_effort zu steuern (minimal, low, medium, high), ist ein direktes Werkzeug zur Optimierung von Performance und Kosten. Dieser Ansatz formalisiert eine Praxis, die erfahrene Entwickler bereits aus der Arbeit mit Modellen wie Anthropic's Claude kennen. Dort wird häufig mit Metaprompts in Form von XML-Tags wie <thinking> oder <scratchpad> gearbeitet. Damit weist man das Modell an, seine "Gedankengänge" explizit zu formulieren und ein Problem schrittweise zu zerlegen, bevor es die finale Antwort generiert.

GPT-5 hebt dieses Konzept nun von einer reinen Prompting-Konvention auf die Ebene eines nativen API-Parameters. Statt die KI durch den Prompt zur Reflexion zu bewegen, steuerst du die kognitive Tiefe direkt und damit wesentlich zuverlässiger. Jeder reasoning-Schritt verursacht Latenz und verbraucht Tokens, aber diese explizite Steuerung erlaubt eine präzisere Abwägung zwischen Aufwand und Ergebnis als je zuvor.

high: Dieser Modus eignet sich für Aufgaben mit hoher Komplexität, wie das Entwerfen einer Microservice-Architektur, das Refactoring von tiefgreifendem Legacy-Code oder das Erarbeiten eines neuartigen Algorithmus.lowoderminimal: Für Standardaufgaben wie das Generieren von Docstrings, das Schreiben einfacher Unit-Tests oder das Konvertieren zwischen Datenformaten (z.B. JSON zu YAML) ist dieser Modus ideal. Er verhindert Over-Engineering und minimiert API-Kosten und Antwortzeiten.

Metaprompting via XML: Konfiguration als Code

Die Empfehlung, XML-ähnliche Tags zur Strukturierung von Anweisungen zu verwenden, ist im Kern eine Form des Metaprompting. Statt Konfigurationen in Prosa zu beschreiben, werden sie als strukturierte Daten direkt im Prompt übergeben. Dies ist vergleichbar mit dem Übergeben eines Konfigurationsobjekts an eine Funktion. Für Entwickler eröffnet dies die Möglichkeit, komplexe Spezifikationen maschinenlesbar zu definieren.

Man stelle sich die Definition eines API-Endpunkts direkt im Prompt vor:

XML

<ApiEndpoint path="/users/{id}"> <Method>GET</Method> <PathParameter name="id" type="integer"/> <Response on="200"> <Schema type="object"> <Property name="username" type="string"/> <Property name="email" type="string"/> </Schema> </Response> </ApiEndpoint>Eine solche Struktur ist für das Modell unmissverständlich und führt zu präziserem Code, der exakt der Spezifikation entspricht.

Vom imperativen zum deklarativen Prompting

Frühere Modelle erforderten oft eine imperative, fast schon dominante Sprache. Bei GPT-5 führt dies zu suboptimalen Ergebnissen. Das Modell neigt bei zu forschen Anweisungen zur Überreaktion, was sich technisch in einer exzessiven Anzahl an Tool-Calls oder einer Überfrachtung des Kontext-Fensters manifestiert. Der Ansatz wandelt sich hin zu einem deklarativen Stil: Statt dem Modell zu sagen, wie es eine Aufgabe lösen soll, deklariert der Entwickler das gewünschte Ergebnis und dessen Constraints. Das Modell wählt den Lösungsweg zunehmend autonom.

Interne TDD: Planung als Vorbedingung für Code

Eine der leistungsfähigsten neuen Techniken ist die Anweisung an das Modell, vor der Code-Generierung eine interne Planungs- und Validierungsphase durchzuführen. Man kann GPT-5 anweisen, zunächst eine Art "Rubrik" oder einen Kriterienkatalog zu erstellen, der die Anforderungen an die Lösung definiert. Dies ähnelt einem automatisierten Test-Driven Development (TDD), bei dem die Tests (die Rubrik) vor der Implementierung geschrieben werden. Dies könnte die Iterationszyklen drastisch verkürzen, da der erste generierte Code-Entwurf bereits intern gegen eine selbst erstellte Spezifikation validiert wurde. Das ist besonders relevant für Code, der strikte Performance-, Sicherheits- oder Style-Guide-Anforderungen erfüllen muss.

Steuerung autonomer Agenten: Tool-Budgets und CI/CD-Tauglichkeit

Die Proaktivität des Modells, sein „Eifer“, lässt sich nun gezielt steuern. Durch die Zuweisung eines „Tool-Budgets“ können Entwickler die maximale Anzahl an API-Aufrufen begrenzen und so Kosten und Ausführungszeit kontrollieren. Besonders wichtig für die Automatisierung, etwa in CI/CD-Pipelines, ist die Anweisung, bei Unsicherheiten plausible Annahmen zu treffen, anstatt auf menschliches Feedback zu warten. Ein autonomer Agent kann so angewiesen werden, eine Operation durchzuführen und seine Annahmen zu dokumentieren, anstatt den gesamten Prozess anzuhalten. Dies ermöglicht den Einsatz in Szenarien, die keine interaktive Session erlauben, und ist ein entscheidender Schritt hin zu robusteren, autonomen Entwickler-Tools.